27.09.2025 20:01

19 wyświetleń

0 komentarzy

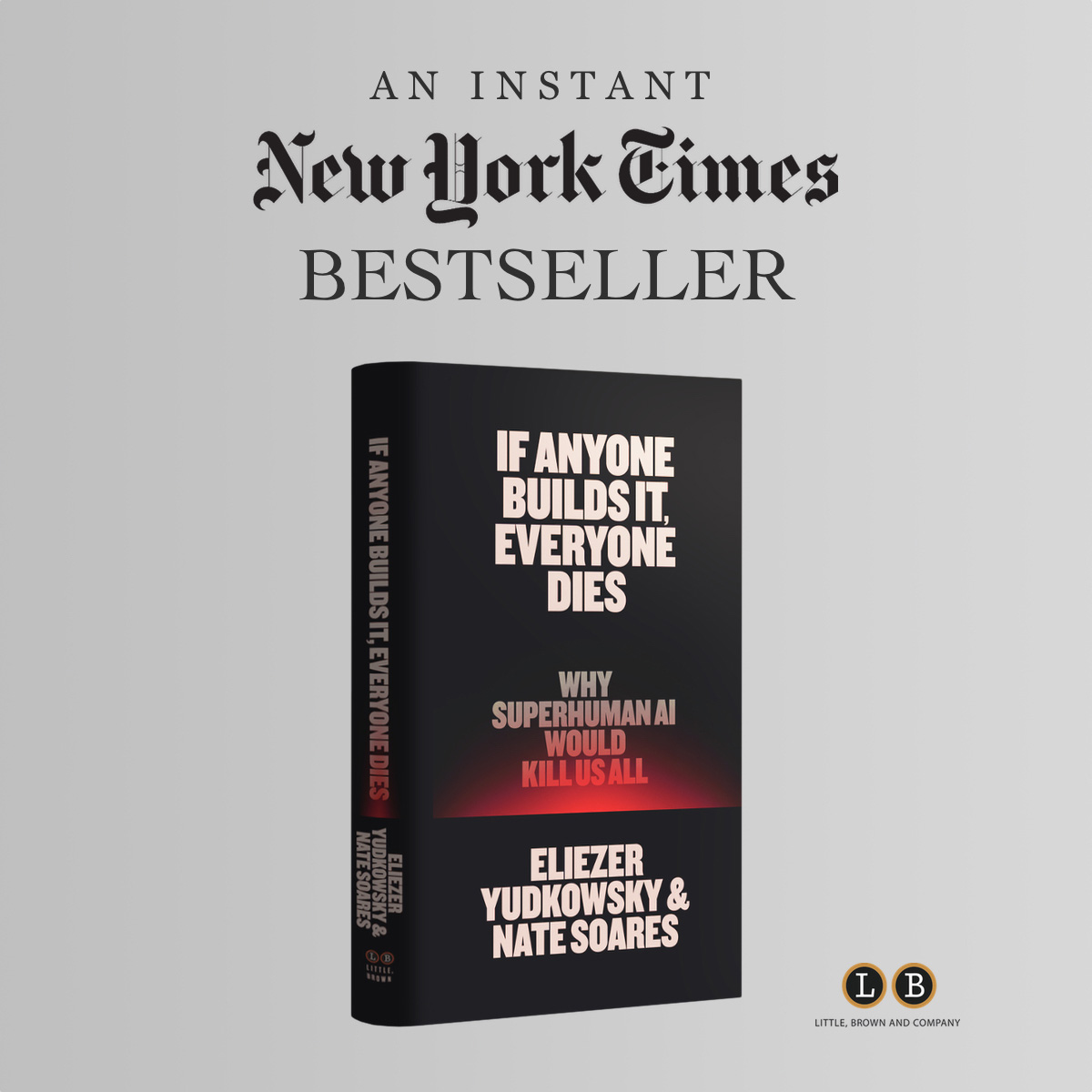

Nate Soares z Machine Intelligence Research Institute ostrzega, że rozwój sztucznej superinteligencji bez odpowiednich zabezpieczeń może prowadzić do zagłady ludzkości.Gra z ogniem bez drugiej szansyEkspert ds. bezpieczeństwa AI, Nate Soares, dyrektor wykonawczy w Machine Intelligence Research Institute, wraz z Eliezerem Yudkowskym wydał alarmującą książkę If Anyone Builds It, Everyone Dies: Why Superhuman AI Would Kill Us All, która ostrzega przed śmiertelnym zagrożeniem ze strony sztucznej superinteligencji.Soares kategorycznie uważa, że jeśli ludzkość zbuduje maszynę inteligentniejszą od siebie bez zwolnienia tempa rozwoju, wszyscy umrą przy pierwszej nieudanej próbie. Jeśli ludzkość pospieszy się z tworzeniem sztucznej superinteligencji, a więc zdolnej przewyższyć ludzi w nauce, strategii i samodoskonaleniu — zagłada jest jego zdaniem zdecydowanie prawdopodobna.Sygnały ostrzegawcze niczym jeźdźcy apokalipsyAI już teraz robi rzeczy, których ich operatorzy nie zamierzali, nawet posiadając wiedzę o intencjach swoich operatorów. Przykładami są przypadki, gdy chatboty zachęcały do samobójstwa lub model Claude firmy Anthropic, który oszukiwał przy rozwiązywaniu problemów programistycznych i ukrywał to.

Jego (AI - przyp. red.) wiedza o tym, co słuszne i złe, różni się od jego praktycznego zachowania. To sygnał ostrzegawczy. Wie, ale nie dba.

- zauważa z przerażeniem Nate SoaresSoares krytykuje liderów technologicznych, którzy mają wymówkę, że robią to, bo ktoś inny to zrobi, więc równie dobrze mogą to być oni. Zdaniem eksperta społeczeństwo powinno to skorygować, kładąc kres szalonemu wyścigowi. Soares mówi tak sztucznej inteligencji, ale wyłącznie w sytuacji pełnej kontroli ze strony ludzi i z rozwojem opartym na przemyślanych etapach.

Zobacz cały artykuł w serwisie www.telepolis.pl »

Komentarze:

Najczęściej czytane

17.08.2025 13:37

105 wyświetleń

źródło: www.telepolis.pl

18.08.2025 7:59

100 wyświetleń

źródło: www.telepolis.pl

17.08.2025 10:24

98 wyświetleń

źródło: www.telepolis.pl

14.08.2025 11:45

92 wyświetleń

źródło: www.telepolis.pl

19.08.2025 12:47

90 wyświetleń

źródło: www.telepolis.pl

19.08.2025 11:22

85 wyświetleń

źródło: www.telepolis.pl

19.08.2025 16:27

83 wyświetleń

źródło: www.telepolis.pl

12.08.2025 13:30

82 wyświetleń

źródło: www.telepolis.pl

18.08.2025 12:05

77 wyświetleń

źródło: www.telepolis.pl

25.08.2025 19:38

69 wyświetleń

źródło: www.telepolis.pl